예상했던 일이다. 기업의 비즈니스에 데이터가 큰 영향을 미칠 것이란 사실을. 예나 지금이나 데이터는 기업에게 중요한 자산이다. 어떻게 사용하느냐가 관건이다. 만약 망망대해에서 민물 릴을 사용한다고 생각해보자. 보지 않아도, 실행에 옮기지 않아도 결과는 뻔하다.

급증하는 데이터를 효과적으로 사용하기 위한 노력은 변함이 없다. 다만 방법을 잘 알지 못했을 뿐이다. Hadoop은 일반 서버 컴퓨터를 사용해 거대한 데이터를 분산 처리하는 오픈소스 소프트웨어다. 가격도 저렴하지만 다양하게 확장할 수 있는 오픈소스란 점에서 장점을 가진다. Hadoop이란 단어가 생소하게 느껴지겠지만, 이 소프트웨어는 이미 실생활과 맞닿아 있다. 예를 들어 개인이 책상을 구매하고자 한 최적의 상점과 가격 등의 관련 정보를 제시하거나 길을 찾는 데 도움을 준다. 이러한 장점으로 인해 기업은 가치 있는 데이터를 추출하기 위해 Hadoop을 빠르게 도입하고 있다. Hadoop은 Google 검색 엔진에서 테라바이트나 페타바이트 수준의 방대한 데이터를 처리하기 위해 사용되던 기술이었다. Google은 2003년 대규모 분산 파일 시스템 ‘Google File System(GFS)’ 논문과 2004년 대규모 분산 프로그래밍 모델 ‘MapReduce’ 논문을 각각 발표했다. Hadoop은 이런 내용을 바탕으로 2005년, 전 야후 엔지니어였던 더그 커팅(Doug Cutting)에 의해 개발됐다.

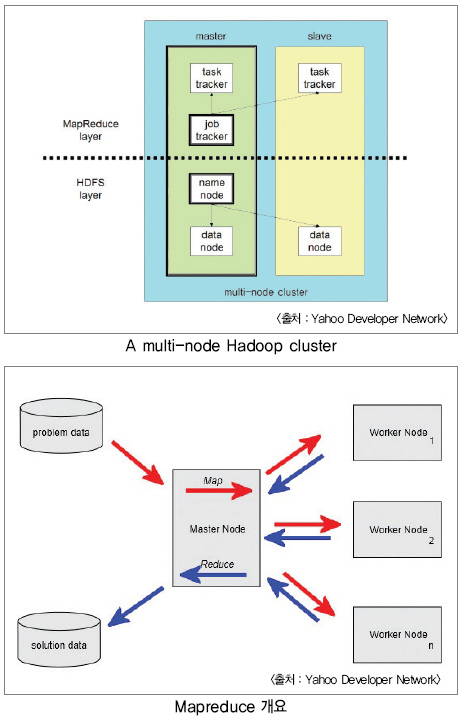

Hadoop은 GFS에 해당하는 HDFS(Hadoop Distributed File System)와 MapReduce(분산 처리 프레임워크)에 하나의 마스터 서버와 여러 개의 클러스터로 구성된다. 특히 부분적인 고장에 강하며 서버를 추가해 쉽게 저장 용량과 성능을 확장하기 쉽다.

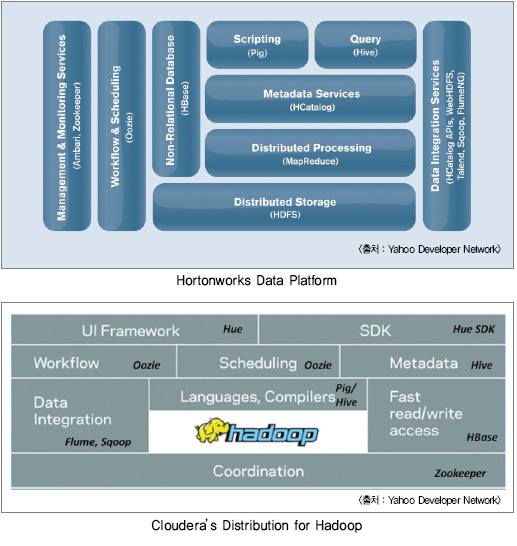

Hadoop을 서비스하는 대표적인 업체로는 Cloudera와 Hortonworks를 들 수 있다. Hortonworks는 야후에서 분사 후 Hadoop 코어 기술과 아키텍처 개선 등을 담당하고, Cloudera는 빅 데이터와 클라우드 시장의 기술 지원, 교육 및 배포판을 제공한다. 이밖에도 엔터프라이즈 업체로는 MapR이 있다. Hadoop을 사용하는 국내 업체는 네이버와 다음 등 인터넷 기업과 S 클라우드를 준비하는 삼성전자와 같은 제조사 역시 스마트폰, 스마트 디바이스를 위한 콘텐츠 서비스와 이를 통해서 발생하는 엄청난 로그 데이터 처리를 위해 Hadoop을 적극적으로 활용하고 있다. 또한 넥스알(NexR)이 Hadoop 및 클라우드 기술을 기반으로 다양한 컨설팅 및 사업을 추진하고 있으며, 최근에는 RHive라는 R(분석 엔진)과 Hive를 결합한 시스템을 오픈소스로 공개하는 등 국내의 Hadoop 저변 확대에 많은 지원을 하고 있다.

다양한 에코시스템

최근 Hadoop을 통한 다양한 에코시스템이 구축되면서 비정형 데이터와 정형 데이터 처리가 가능해졌다. Hadoop의 분석 기술은 통계와 데이터마이닝, 기계 학습, 패턴 인식 등이 포함되며, 저장장치를 병렬로 연결시켜 별도의 스토리지가 필요하지 않아 대규모 데이터를 빠르게 비용 효율적으로 처리하는데 적합하다. 이러한 기술은 데이터의 안정성 및 정합성보다 속도와 비용에 초점을 맞췄기 때문에 일부 데이터의 유겮濫퓽?발생해도 처리 결과가 영향을 받지 않는 업무에 적합하다. 또한 표현 기술은 분석된 데이터의 특징이나 의미를 쉽게 알 수 있도록 나타내는 것을 의미한다.

대표적인 표현 기술로는 R로 통계 계산 및 시각화를 위한 언어, 개발환경을 제공하며 기본적인 통계 기법으로부터 모델링, 최신 데이터마이닝, 시뮬레이션, 수치해석 기법까지 구현이 가능하다. 구현 결과는 그래프 등으로 시각화할 수 있고 다른 프로그래밍 언어와 연결도 용이하다.

구현 사례

뉴욕타임즈는 과거 게재했던 기사를 PDF 파일로 서비스하길 원했다. 문제는 130여 년 전 기사부터 서비스를 시작한다는 것이었다. 이 양은 무려 1,100만 여개의 기사에 달했다. 기존 기사를 TIFF 형식으로 스캔하자 약 4테라바이트에 달하는 이미지 데이터가 추출됐다. 뉴욕타임즈는 Amazon Web Services LLC가 전개하는 IaaS ‘Amazon EC2’를 이용해 100노드로 구성된 Hadoop 클러스터를 구축했다. 4테라바이트 이미지 데이터를 24시간 만에 약 1.5테라바이트의 PDF 데이터로 변환했다. 작업에 들어간 비용도 불과 240달러였다.

현재 뉴욕타임즈는 Hadoop을 Web 검색 로그의 수집·분석에 사용하고 있다. 또한 EC2에 구축한 20대의 서버로 구성된 Hadoop 클러스터를 이용해 12테라바이트에 달하는 데이터를 처리/쿠키 추적으로 회사의 사이트를 방문한 순, 방문자수, 총 PV, 사용자 당 PV를 집계하고 있다.

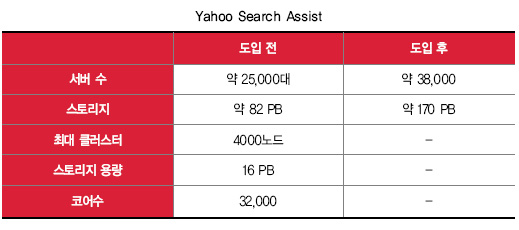

Yahoo는 검색 엔진이나 메일 서비스 등 각종 Web 서비스를 전개하는 회사다. Yahoo의 주 수입원은 포털 사이트에 게재되는 광고를 들 수 있다.

Yahoo는 사용자마다 각기 다른 콘텐츠와 광고를 게재한다. 이것은 사용자 액세스 기록을 분석해 콘텐츠나 광고를 최적화했기 때문이다. Yahoo는 포털 사이트에 콘텐츠나 광고 최적화, 스팸 필터 등에 Hadoop을 활용한다. 특히 검색 지원 기능 ‘Search Assist’에 Hadoop을 적용해 3년 간 로그 분석 처리를 20분 만에 해결했다. 기존 C++에서는 26일이란 시일이 걸렸다.

페이스북은 Hadoop을 자사의 몇 가지 툴과 함께 이용하고 있다. 예를 들어 여러 Web 서버에 저장된 액세스 로그를 Hadoop 클러스터에 저장하기 위해 분산 로그 수집 소프트웨어 ‘Scribe’를 사용한다. 또한 액세스 로그는 Hive로 분석한다.

Hive는 Hadoop의 분산 처리 프레임 워크 ‘MapReduce’를 프로그래밍 없이 쉽게 개발할 수 있는 툴이다. 특히 SQL과 유사한 쿼리 언어 ‘HiveQL’을 이용할 수 있다는 장점이 있다. 가령 SELECT에서 HDFS에 축적된 데이터를 검색하거나 INSERTOVERWRITE에서 HDFS에 데이터를 저장할 수 있는 다른 데이터를 가공/결합할 수 있다.

HiveQL은 자동으로 MapReduce 작업으로 변환돼 기존 SQL을 사용했던 엔지니어도 쉽게 MapReduce의 이점을 얻을 수 있다. Facebook은 약 200명의 직원이 일상적으로 Hive를 사용하며 약 95 %의 MapReduce 작업이 Hive를 통해 진행한다. 이처럼 Hadoop은 Scribe와 Hive 등의 주변 기술과 결합해 종래와 같이 정기적으로 실행되는 전형적인 일괄처리뿐만 아니라 방대한 데이터의 일괄처리도 가능하다.

.jpg)

Hadoop과 RDB와의 관계

IT시스템에서 RDBMS(관계형 데이터베이스 관리 시스템)는 데이터 저장에 많이 사용되고 있다. 기업이 RDBMS를 주로 사용하는 이유는 트랜잭션 처리로 데이터를 일관성 있게 유지할 수 있고 완성도 높은 구현이 가능하기 때문이다. 또한 엔지니어가 RDB 데이터 모델과 인터페이스 SQL에 친숙하다는 점도 들 수 있다. 그러나 RDBMS는 높은 일관성을 제공하지만 서버 처리량이 많은 작업을 병렬로 확장하는 것이 어렵다. 처리하는 데이터 규모를 늘리려면 하드웨어 도입이 필요하다. 이와 달리 Hadoop은 수천 대 수준까지 확장할 수 있는 구조로 저렴한 하드웨어를 사용해 페타바이트 급 이상의 대용량 데이터 처리가 가능하다. 반면에 RDBMS가 제공하는 동일 데이터를 읽고 쓰는 고급 트랜잭션 제어나 인덱스의 빠른 랜덤 액세스 등의 기능은 없다.

Hadoop의 HDFS에 저장된 파일은 기본적으로 수십 메가바이트 이상으로 데이터 블록으로 취급된다. MapReduce는 응용 프로그램에서 데이터 액세스 시, 특정 디렉토리의 데이터 파일을 전체 스캔하는 방법을 주로 사용한다. Hadoop은 데이터 파일 중 어떤 형식이나 구조가 포함됐는지 사용자와 응용 프로그램이 파악하고 대응해 Hadoop 프레임워크에서 관리되지 않는다. 즉, Hadoop과 RDB는 서로 다른 목적으로 사용되며 RDBMS를 이용해 만들어진 시스템을 단순히 Hadoop에서 대체할 수 없다는 것이다. 하지만 기존 시스템은 RDBMS를 많이 사용하고 있기 때문에 지금까지 RDB에 저장/처리한 데이터를 마이그레이션하거나 특정 부분에서 Hadoop의 도입을 검토하고 있다.

새로운 기회 제공

기존 빅 데이터는 수집/축적이 어렵다는 이유로 사용하지 못했다. 하지만 Hadoop은 방대한 데이터를 고속으로 일괄처리할 수 있어 기업에게 새로운 기회를 제공할 수 있다. 이런 특징 때문에 Hadoop의 용도가 기존 데이터를 일괄처리하는 데에만 한정시킬 수 있다. 하지만 Hadoop의 본질은 기존에 처리할 수 없던 방대한 데이터 처리와 새로운 영역의 비즈니스를 가능하게 한다는 것이다. ES

|

Cloudera, 초 병렬 SQL 수준 유지 Cloudera는 작년 10월 ‘Strata + Hadoop World’에서 업계 처음으로 Hadoop용 실시간 쿼리 엔진인 ‘Cloudera Enterprise’를 발표했다. 이 솔루션은 비정형·정형 데이터를 불문하고 대규모 확장 시스템에 존재하는 모든 형태의 데이터를 일괄처리할 수 있으며 실시간 운영이 가능하다. 특히 중앙 빅 데이터 플랫폼을 제공해 기업의 대규모 데이터를 효과적으로 관리할 수 있다. Ovum의 Tony Baer 수석 애널리스트는 “Hadoop을 도입하는 주요 기업은 기존 DW(Data warehouse)와 BI(Business Intelligence)를 활용해 인터렉티브 쿼리를 실행하는 즉석 분석에 익숙해져 있다”며 “Cloudera는 새로운 Impala 엔진으로 강화된 실시간 쿼리 기능을 통해 성능 및 접근성을 초 병렬 SQL 플랫폼과 동일한 수준으로 유지하고 있다”고 말했다. 맥심, 단일 위상 에너지 측정 프로세서 Maxim Integrated는 78M6610+PSU/78M6610+LMU 단일 위상 에너지 측정 프로세서를 출시했다. 이들 프로세서 제품은 단일칩 에너지 측정 서브시스템을 제공한다. 이들 프로세서를 이용함으로써 기존에 필요하던 전력 미터 시스템-온-칩을 이용할 필요 없이 기존 디자인으로 전력 회사 등급의 검출 및 진단 기능을 편리하게 추가할 수 있다. 이들 제품은 최종 애플리케이션 요구를 충족하는 각기 고유의 펌웨어를 포함한다. 78M6610+PSU는 데이터 센터, 서버, 통신, 데이터 장비의 실시간 모니터링에 이용하도록 설계되었으며, 78M6610+LMU는 범용적인 솔루션으로써 가전기기, 스마트 플러그, EV 충전기, 태양열 인버터 등의 애플리케이션에 이용하기에 적합하다. 78M6610 프로세서는 에너지 측정 기능을 제공하는 것으로써 제조비용을 낮추고 출시 시간을 단축할 수 있다. 에너지 측정 솔루션은 기존에는 추가적인 마이크로컨트롤러를 사용해야 했으므로 디자인 비용을 크게 증가시키고 수개월의 추가적인 개발 시간을 필요로 했다. 78M6610을 이용하면 비용을 증가시키거나 디자인을 변경할 필요 없이 기존 디자인으로 포괄적인 에너지 미터를 편리하게 추가할 수 있다. 한편 78M6610+PSU는 24핀 QFN 및 16핀 TSSOP 패키지와 78M6610+LMU는 24핀 QFN 패키지로 제공된다. |

<저작권자(c)스마트앤컴퍼니. 무단전재-재배포금지>