글|차 원 용 소장, 아스팩미래기술경영연구소(wycha@nuri.net)

인공지능(AI)-기계학습(ML)-딥러닝(DL)의 관계, 지도학습과 비지도학습, GPU와 CPU에서의 학습과 구동, ML-DL 대가들의 영입과 인수합병, 경쟁사들의 최근 행보, 그리고 페이스북의 그간 연구결과를 살펴봄으로써, AI-ML-DL이 메신저 플랫폼으로 업그레이드되고 타 서비스들과 융합됐을 때 페이스북의 미래 경쟁력과 그에 따른 통찰을 제공한다.

인공지능-기계학습-딥러닝

인공지능은 최고 높은 상위 개념이다. 우리 인간의 뇌와 뉴런 신경망을 모방하여 언젠가는 컴퓨터나 로봇이 인간처럼 사고하고 행동하도록 하는 것이다. 우리는 사진만으로 개와 고양이를 아주 쉽게 구별할 수 있지만 컴퓨터는 구별하지 못한다. 이를 위해 기계학습(Machine Learning, ML)이라는 방법이 고안됐다. 많은 데이터를 컴퓨터에 입력하고 비슷한 것끼리 분류하도록 하는 기술이다. 저장된 개 사진과 비슷한 사진이 입력되면, 이를 개 사진이라고 컴퓨터가 분류하도록 하는 것이다.

데이터를 어떻게 분류할 것인가를 놓고 이미 많은 기계학습 알고리즘이 등장했다. 의사결정나무(Decision Tree)나 베이지안망(Bayesian network), 서포트 벡터 머신(support vector machine, SVM), 인공신경망(Artificial neural network, ANN) 등이 대표적이다. 의사결정나무는 의사결정 규칙(Decision Rule)을 나무 구조로 도표화해 분류와 예측을 수행하는 분석방법이다.

베이지안망은 다수의 변수들 사이의 확률적 관계(조건부 독립성: conditional independence)를 그래프 구조로 표현하는 모델이다. 베이지안망은 비지도(감독/교사) 학습(unsupervised learning)을 통한 데이터 마이닝(data mining)에 적합하다. 서포트 벡터 머신은 패턴 인식과 자료 분석을 위한 지도(감독/교사) 학습(supervised learning)의 모델이며, 주로 분류와 회귀 분석을 위해 사용한다.

이 중 딥러닝(Deep Learning, https://en.wikipedia.org/wiki/Deep_learning)은 인공신경망의 후예다. 인공신경망을 이용해 데이터를 군집화하거나 분류하는 데 사용하는 기술이 바로 딥러닝이다. 기계학습과 인지과학에서의 인공신경망은 생물학의 신경망(동물의 중추신경계, 특히 뇌)에서 영감을 얻은 통계학적 학습 알고리즘이다. 인공신경망은 시냅스(synapse)의 결합으로 네트워크를 형성한 인공 뉴런(노드)이 학습을 통해 시냅스의 결합 세기를 변화시켜, 문제해결 능력을 가지는 모델 전반을 가리킨다.

지도(감독/교사) 학습과 비지도학습

인공신경망을 이용하는 딥러닝의 핵심은 분류를 통한 예측이다. 수많은 데이터 속에서 패턴을 발견해서 인간이 사물을 구분하듯 컴퓨터가 데이터를 나눈다. 이 같은 분별 방식은 두 가지로 나뉜다. 지도자(감독자/교사)의 신호(정답) 입력에 의해서 문제에 최적화되어 가는 지도(감독/교사)학습과 지도자의 교사 신호를 필요로 하지 않는 비지도(감독/교사)학습이 그것이다.

기존의 기계학습 알고리즘은 대부분 지도학습에 기초한다. 지도학습 방식은 컴퓨터에 먼저 정보를 가르치는 방법이다. 예를 들어 사진을 주고 ‘이 사진은 고양이’라고 알려주는 식이다. 컴퓨터는 미리 학습된 결과를 바탕으로 고양이 사진을 구분하게 된다. 비지도학습은 이 배움의 과정이 없다. ‘이 사진이 고양이’라는 배움의 과정 없이 ‘이 사진이 고양이군’이라고 컴퓨터가 스스로 학습하게 된다. 따라서 비지도학습은 컴퓨터의 높은 연산 능력이 요구된다. 구글이 현재 비지도학습 방식으로 유튜브에 등록된 동영상 중 고양이 동영상을 식별하는 딥러닝 기술을 개발한 상태다.

일반적으로 명확한 해답이 있는 경우에는 지도학습이, 데이터 클러스터링과 마이닝에는 비지도학습이 이용된다. 인공신경망은 많은 입력에 의존하면서 일반적으로 베일에 싸인 함수를 추측하고 근사치를 낼 경우에 사용한다. 일반적으로 입력으로부터 값을 계산하는 뉴런 시스템의 상호연결로 표현되고 적응성이 있어 패턴 인식과 같은 기계학습을 수행할 수 있다. 데이터로부터 학습하는 다른 기계학습과 같이, 신경망은 일반적으로 규칙 기반 프로그래밍으로 풀기 어려운 컴퓨터 비전(시각, vision) 또는 음성인식과 같은 다양한 범위의 문제를 푸는 데 이용한다.

GPU냐 CPU냐?

딥러닝에서 학습(훈련)을 위해서는 많은 데이터를 이용하여 학습시키는 것이 매우 중요하다. 많은 학습 데이터를 반복해서 학습시키는 데에는 많은 시간이 소요되는데, 이러한 이유로 컴퓨팅 파워가 약한 과거의 중앙처리장치(CPU)로는 많은 학습 데이터를 처리하는데 너무 많은 시간이 소요돼 실용적이지 못했다. 요즘 CPU는 과거에 비해서 비교적 빠른 처리를 할 수 있으나 획기적으로 빠른 학습을 위해 그래픽카드에 사용되는 그래픽처리장치(GPU)를 이용하면서 딥러닝의 성능이 크게 향상됐다.

요즘 PC에 꽂을 수 있는 GPU는 3,000개 이상의 처리 코어를 가지고 있어서 동시에 병렬적(parallel)으로 딥러닝에 사용되는 수치 계산을 할 수 있다. 일반적으로 이미지(얼굴/사물) 인식부터 음성인식 등 다양한 기계학습 작업을 실제 수행할 때는 GPU나 CPU를 장착한 스마트 기기에서 구동된다. 특히 구글은 인공지능 서비스를 훈련(학습)시킬 때뿐만 아니라 구동할 때에도 GPU 기반 스마트 기기를 활용하고 있다.

GPU는 엄청나게 많은 작은 데이터를 병렬처리할 수 있는 장점이 있으나, 데이터가 계속 데이터센터에 제공될 때만 효율적이라는 단점이 있다. 이런 이유로 구글은 2015년 11월 일본 도쿄에서 자체 개발한 기계학습 기술인 텐서플로(TensorFlow)를 오픈소스 프로젝트로 공개하고 외부에서도 무료로 쓸 수 있도록 했다. 스마트 기기의 CPU에서도 바로 구동하도록 하기 위함이다.

반면, 페이스북은 시스템 상에서 음성인식 서비스를 훈련시킬 때는 GPU를 활용하지만, 이용자에게 얼굴인식 기능 등을 구현해줄 때는 스마트 기기의 CPU를 이용한다. 그 이유는 기계학습과 딥러닝에서는 고객의 경험 데이터가 중요하기 때문인데, 이미 페이스북은 월별 고객 15억 명을 확보하고 있으며, 15억 명의 풍부한 감성(좋아요… 등) 및 다양한 포스팅의 데이터를 확보하고 있다. 이 경우 고객 접점의 딥러닝을 통해 고객에게 최적화된 맞춤식 서비스를 제공할 수 있다.

ML- DL 대가들의 영입과 인수합병

뉴욕대의 얀 레쿤(Yann LeCun) 교수, 캐나다 토론토대의 제프리 힌튼(Geoffrey Hinton) 교수, 스탠포드대의 앤드류 응(Andrew Ng) 교수는 인공지능-기계학습-딥러닝의 선구자로 불리는 3인방이다. 여기에 레이 커즈와일(Ray Kurzweil)이라는 천재 과학자가 있다. 이들 4명은 인공지능에 관한 세계 4대 천왕이라 불려도 손색없다.

페이스북의 AI 연구를 지휘하는 인공지능연구소장은 딥러닝의 제1인자인 얀 레쿤이며, 구글과 애플에 대항하기 위해 페이스북은 야니브 타이그만(Yaniv Taigman)이 개발한 얼굴인식 소프트웨어인 딥페이스(DeepFace)를 개발한 스타트업인 페이스(Face.com)를 2007년 인수했으며, 2015년 1월에는 8명의 머신 러닝 팀으로 시작한 팔로알토(Palo Alto)의 스타트업인 윗.에이아이(Wit.ai)를 인수했는데, 이들은 음성 비서인 M을 연구 관리하고 있다(Recode, 5 Jan 2015).

4인방 중 레이 커즈와일은 2012년, 제프리 힌튼은 2013년 구글에 합류했다. 레이 커즈와일은 2012년 12월부터 구글 엔지니어링 이사로 인공지능과 양자컴퓨팅을 진두지휘하고 있다. 구글은 2014년 기계학습과 신경망을 이용하여 스스로 학습하는 알고리즘인 DQN(Deep Q-Network)을 개발한 벤처기업인 영국 런던 소재의 딥마인드(DeepMind)를 인수했다. 딥마인드 개발자 데미스 하사비스(Demis Hassabis) 또한 알려진 실력자다. 기계학습에 관한 한 구글은 엄청난 인재를 끌어 모은 셈이다. 구글이 기계학습에서 조금씩 성과를 내는 이유다.

중국의 바이두는 2014년 5월 구글의 인공지능 연구를 이끌었던 앤드류 응을 영입한 데 이어, 향후 5년간 3억 달러(약 3600억 원)를 투입해서 AI 연구소와 개발부서 인원을 확충한다는 계획을 밝혔다.

경쟁사의 ML 오픈소스 공개

페이스북 - 오픈소스 토치(Torch) DL 모듈 최초 공개

페이스북은 2015년 1월 16일 토치(Torch, http://torch.ch)를 위한 오픈소스의 딥러닝 모듈을 다른 경쟁사들보다 먼저 공개했다(Venturebeat, Techcrunch, Facebook Blog, 16 Jan 2015). 페이스북의 FAIR에서 많은 연구 프로젝트가 토치를 사용한다. 토치는 오픈소스 개발 환경으로 계산, 기계학습, 컴퓨터 비전을 다룰 때 딥러닝과 나선형 신경망(convolutional neural network, CNN, ConvNet)(Wikipedia)을 특별히 강조할 때 사용한다. 따라서 토치는 대학 연구소, 구글/딥마인드, 트위터, 인텔, NVIDA, AMD 등 많은 기업들이 사용한다.

공개된 오픈소스 모듈은 대용량 ConvNets뿐만 아니라 자연언어처리(NLP) 애플리케이션에서 주로 많이 사용되는 산재된 활동들을 다루는 네트워크를 위한 그래픽처리장치(GPU)에 최적화된 모듈이다. 이에 대한 자세한 내용은 다음 사이트의 페이퍼를 참조하면 된다(http://arxiv.org/abs/1412.7580).

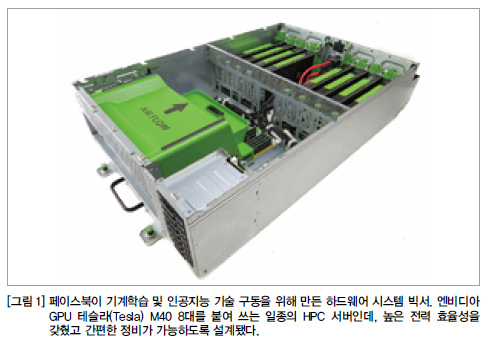

페이스북 - 기계학습 하드웨어인 빅서(Big Sur) 오픈소스로 공개

페이스북의 인공지능리서치(FAIR) 팀이 엔비디아와 손잡고 기계학습 기술을 구동하기 위한 하드웨어 시스템 설계를 오픈소스로 공개했다. 신경망 트레이닝을 위해 설계한 차세대 하드웨어인 코드명 ‘빅서(Big Sur)’를 공개한 것이다(Facebook, 10 Dec 2015).

빅서는 대규모 인공지능 컴퓨팅을 위해 최신 ‘오픈 랙(Open Rack)’ 호환 하드웨어로 설계됐다. 오픈 랙은 페이스북의 대규모 데이터센터 인프라 최적화를 위해 오픈소스 방식으로 하드웨어 및 데이터센터 기술을 표준화하는 ‘오픈 컴퓨트 프로젝트(Open Compute Project, OCP)’의 랙 규격이다. 페이스북 엔지니어 케빈 리(Kevin Lee)와 서칸 피안티노(Serkan Piantino)는 공식 개발자 블로그를 통해서 빅서 하드웨어를 완전히 새로 개발했으며, OCP 기반 데이터센터에서 운영되는 서버인 만큼 기성 솔루션보다 다양한 기능을 갖췄다고 강조했다.

이런 기술과 설계 결과물을 향후 OCP에 공개하겠다고 발표했다. 빅서 기술은 OCP 표준 데이터센터처럼 외기 냉각(free-air cooled) 환경에서도 운영될 수 있는 온도와 전력 효율성을 갖춘 새로운 서버에 최적화됐다. 페이스북이 먼저 도입했던 기성 고성능 컴퓨팅(HPC) 시스템처럼 냉각 등에 특화된 기술을 사용하지 않아도 된다.

엔비디아의 고성능 GPU인 테슬라 M40 액셀러레이터(NVIDIA’s Tesla Accelerated Computing Platform)는 2015년 11월에 출시됐는데, 페이스북은 이것을 최초로 운영체제(OS)에 적용한 회사다. 테슬라 M40은 ‘딥뉴럴 네트워크(Deep Neural Network, DNN)’ 시장을 겨냥해서 나왔다. 페이스북은 ‘테슬라 액셀러레이티드 컴퓨팅 플랫폼’을 통해, 이전 세대 시스템의 2배 성능을 얻었다고 밝혔다. 또한 페이스북 측은 빅서 기술을 AI 연구자들에게 더 쉽게 만들어 공유하고 싶다고 밝혔다.

모든 하드웨어 시스템을 공개해 다른 이들이 자신들과 함께 그것을 개선할 수 있기를 기대한다는 입장이다. 향후 디자인 개선을 도와 혁신적인 복잡한 AI 시스템을 만들 바탕이 될 것이란 전망이다. 페이스북 관계자는 “우리는 AI 연구자들이 그들의 기법과 기술을 더 쉽게 공유할 수 있는 자리를 마련할 것”이라며 “이 같은 협업이 더 복잡한 AI 시스템을 만드는데 기여하고 미래 디자인에 혁신을 가져올 것으로 믿는다”고 말했다.

그간 페이스북은 빅서를 통해 이용자에게 맞춤형 콘텐츠를 제공해왔다. AI 기술을 활용해 이용자가 좋아할만한 사진, 비디오, 읽을거리, 게임 등 다양한 뉴스 피드를 보여준다.

구글 - 텐서플로 오픈소스 프로젝트

구글은 2015년 11월 10일 일본 도쿄의 ‘더 매직 인 더 머신(The Magic in the Machine)’ 행사에서 최근 자체 개발한 기계학습 기술인 ‘텐서플로(TensorFlow, http://tensorflow.org)’를 오픈소스 프로젝트로 공개하고 외부에서도 무료로 쓸 수 있도록 했다(그림 2 참조). 이에 따라 외부 개발자들은 텐서플로를 무료로 쓰는 것은 물론, 프로젝트에 참여해 수정도 가능하다.

2015년 11월초 선보인 지메일의 자동 답신 기능 ‘스마트 리플라이(Smart Reply)’를 비롯해 50여 개에 이르는 구글 서비스에는 텐서플로 기술이 적용되고 있다. DNN을 활용한 기계학습 기술을 적용하는 데는 텐서플로가 필수적이기 때문이다. 이를테면 유튜브 동영상에서 고양이를 인식하는 등의 연산을 수행할 수 있는 것도 텐서플로 덕분이다. 이 기술로 구글은 지메일에서 스팸메일을 99.9%나 걸러내고 있다. 구글 번역 역시 기계학습 기술을 적용한 뒤 오류가 23%에서 8%로 떨어졌다.

구글의 컴퓨터 비전 기술은 사진의 이정표를 인식해서 사진을 정리해 주는 역할을 한다. GPS나 지리 정보가 없이도 중요 지점을 뽑아 다른 사진과 연결시켜주는 역할을 한다. 특히 구글 포토는 많은 사진 속에서 사물, 장소, 사람을 자동으로 인식하고 카테고리로 분류해주는 기능도 갖추고 있다. 또한 인셉셔니즘(inceptionism) 기능을 통해 이미지의 사물을 구별해내고, 옷차림새를 통해 이벤트까지 예측할 수 있다. 구글은 2015년 6월 18일 “인셉셔니즘은 신경망이 어떻게 작동하는지 이해하고 시각화하는 데 도움을 준다”며 “인공신경망이 예술가를 위한 도구가 될 수 있지 않을까 생각한다”고 밝힌 바 있다(Google, 18 Jun 2015).

구글 - 클라우드비전 API와 클라우드 로봇 공개

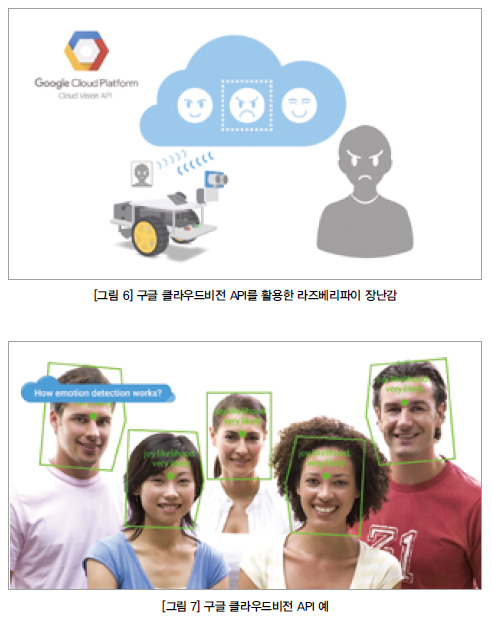

구글은 2015년 12월 2일 머신 비전 기술을 외부개발자들이 쉽게 활용할 수 있도록 클라우드비전(Cloud Vision) API를 공개했다(Google, 2 Dec 2015). 아직 제한된 프리뷰 버전으로, 신청서를 구글에 제출해야 사용할 수 있지만 향후 정식 서비스로 공개된다면 누구나 API를 통해 자신의 앱, 서비스, 하드웨어에 구글의 머신 비전 기술을 적용할 수 있을 전망이다.

그 동안 막대한 자금력으로 강력한 컴퓨팅 리소스와 고급 기계학습 인재를 확보한 몇몇 기업들의 전유물로 여겨왔던 기술에 쉽게 접근할 수 있게 된 것이다. 기계학습 기술이 일부 전문가들만 다룰 수 있는 것이 아니라 API를 다룰 수 있는 정도의 개발자라면 누구나 쉽게 활용할 수 있게 됐다는 점에서 기계학습의 대중화가 시작됐다고도 볼 수 있다.

클라우드비전 API를 이용하면, 외부 개발자들도 자신의 앱에 구글 포토 같은 이미지 인식 기술을 결합시킬 수 있다. 이 API는 우선 이미지 안에 있는 지배적인 객체를 찾아내고 수천 개의 카테고리로 분류해준다. 서비스에 비전 API를 적용하여 보유하고 있는 이미지에 쉽게 메타데이터를 구축할 수 있고, 이를 기반으로 이미지 검색과 사용자 맞춤 추천 등의 기능을 제공할 수 있다.

또 클라우드비전 API는 사람의 얼굴 이미지에서 감정을 읽어낼 수도 있다. 얼굴에서 눈, 코, 입 위치 같은 정보를 인식하고, 또 기쁨, 슬픔 등 여덟 가지 이상의 감정을 읽어낼 수 있다. 광학 문자 인식(OCR) 기능도 담고 있다. 영어뿐만 아니라 다양한 언어를 탐지할 수 있고 어떤 언어인지 자동 인식하는 기능이 탑재돼 있다. 따라서 이미지에 포함된 텍스트를 검색하는 기능을 서비스에 적용할 수 있다.

또 이미지 안에 브랜드 로고가 포함돼 있다면 이를 인식할 수도 있다. 사진 속 인물이 어떤 브랜드 옷을 입고 있는지 확인하고 관련된 맞춤형 정보나 광고를 제공하는 서비스 개발도 가능하다. 이미지 안에 부적절하거나 불쾌한 콘텐츠가 포함돼 있다면 이를 검출해 낼 수도 있다. 불특정 다수의 사용자로부터 수집한 이미지에서 부적절한 이미지를 걸러내는 데 활용할 수 있다. 이 밖에도 잘 알려진 경치나 인공 구조물을 위도, 경도 값과 함께 인식할 수 있다.

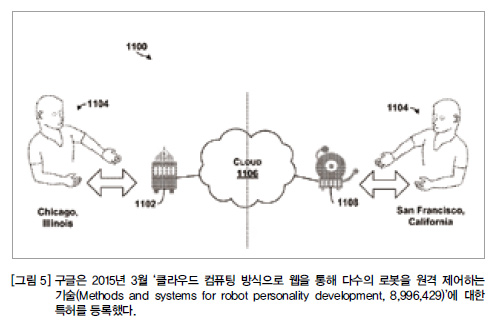

구글은 더 나아가 덱스터(Dexter Industries)의 라즈베리파이(Raspberry Pi) 보드로 만든 소형 로봇인 고피고(GoPiGo)에 클라우드비전 API를 어떻게 적용할 수 있는지 보여주는 데모 영상도 같은 날 공개했다(Youtube via Google, 2 Dec 2015). 고피고 로봇에는 카메라 등의 센서만 탑재하고, 사물과 사람만 감지해서 클라우드로 보내면, 클라우드에서 분석하고 판단하여 다시 로봇에게 지시하고 명령을 내리는 것이다. 이를 클라우드 로봇이라 하는데, 구글은 2015년 3월 ‘클라우드 컴퓨팅 방식으로 웹을 통해 다수의 로봇을 원격 제어하는 기술(Methods and systems for robot personality development, 8,996,429)’이라는 특허를 등록했다(그림 5).

고피고 로봇이 카메라를 통해 웃는 사람의 얼굴을 감지해서 클라우드로 보내면, 클라우드에서 그 웃는 사람의 감정을 분석해 다시 고피고 로봇에 지시하여 로봇이 기쁨, 슬픔 등 여덟 가지 이상의 감정을 음성이나 디스플레이에 표시해주는 것이다. 바나나를 들고 “이것이 무엇이냐”고 로봇에게 물으면 1초안에 “바나나”라고 대답하고, 1달러 지폐를 들고 물으면 “1달러 돈”이라고 대답한다. 이와 같이 이미지 분석은 클라우드에서 처리되기 때문에 컴퓨팅 성능이 낮은 모바일이나 작은 디바이스에서도 API를 활용해 다양한 서비스를 구현할 수 있다(그림 6).

따라서 클라우드비전 API를 활용해 개발자들은 나름대로 다양한 서비스를 만들 수 있다. 예컨대 로봇청소기에 머신비전 기술이 적용된다면, 기분이 안 좋아 보이는 사람 발밑은 청소하지 않을 수 있다. 또 바닥에 떨어져 있는 것이 치워야 할 쓰레기인지 아닌지도 구분해 낼 수 있다. 작은 카메라가 시각장애인들의 눈이 되어 줄 수도 있을 것이다. 가정용 보안 감시 시스템에 적용되면 문밖을 어슬렁거리는 것이 길 고양이인지 도둑인지 구분하는 것도 가능하다.

MS - 기계학습 프로젝트 옥스포드와 툴킷 DMTK 공개

MS는 2015년 4월~5월에 열린 ‘Build 2015’에서 기계학습, 자연어 번역 등에 관한 전문 지식 없이 개발자가 쉽게 스마트한 앱을 개발할 수 있는 프로젝트 옥스포드(Oxford, http://www.projectoxford.ai)의 API를 공개했다. 비전(vision) 영역에는 이미지를 분석하고 썸네일(thumbnails)을 만들 수 있는 컴퓨터 비전 API, 얼굴인식(face) API, 친구들의 얼굴에서 감정을 인식하는 감정(emotion) API가 포함돼 있고, 스피치 영역에는 음성인식(speech) API가 포함돼 있는데, 이는 검색 서비스인 빙(Bing)과 음성 서비스인 코타나(Cortana)가 결합돼 있으며, 언어(language) 영역에는 타이핑 칠 때 스펠(spell)의 에러를 잡아주는 스펠 API와 자연언어 이해 지능 서비스(Language Understanding Intelligent Service, LUIS) API가 포함돼 있다.

얼굴인식 API는 사진에서 사람의 얼굴을 찾아주는데, 두 장의 사진 속 인물이 동일 인물인지를 판별해주어 얼굴인식 인증에 사용할 수 있다. 음성인식 API는 사람의 말을 인식해 실시간으로 번역도 해준다. 컴퓨터 비전 API는 이미지 내용을 이해하는 기술인데, 예를 들어 빌딩 숲을 촬영한 사진이라면 건물, 거리, 풍경 등의 정보를 추출해 문자화해준다. 자연언어 이해 지능 서비스 API는 모든 자연어의 의미를 이해하도록 만들 수 있고, 기계학습을 활용해 시스템의 언어 이해도를 높이게 된다. 사용자가 단어의 용례를 계속 집어넣으면, 훈련을 거듭하면서 문장 속 정확한 맥락을 이해하게 된다. 또한 개발자는 LUIS의 간단한 인터페이스를 통해 쉽게 기계학습을 실행할 수 있다.

2015년 11월 11일에는 사진에 담긴 사람의 여덟 가지 감정을 수치로 나타내는 서비스를 개발해 공개했다(www.projectoxford.ai/emotion).분노(anger), 경멸(contempt), 불쾌(disgust), 공포(fear), 행복(happiness), 중립/무관심(neutral), 슬픔(sadness), 놀라움(surprise) 등 여덟 가지 감정이 수치화돼 표시된다(그림 8).

서비스를 이용하기 위해서는 해당 홈페이지에 접속한 뒤 사진을 업로드해야 한다. 사람 얼굴에 파란색 테두리가 나타나면 테두리 안에 마우스를 올린다. 이 도구는 아직 베타 버전이지만 앞으로 데이터가 모이면 기계학습을 통해 정밀도를 높이게 될 것이다. MS는 맞춤법 검사와 영화 분석이나 화자인식 등 새로운 도구를 계속 공개할 예정이다. MS는 이 프로젝트를 모두 오픈 소스로 제공하고 있다.

2015년 11월 12일, MS는 기계학습 툴킷 DMTK(Distributed Machine Learning Toolkit, https://github.com/Microsoft/DMTK, www.dmtk.io)를 오픈소스 프로젝트 공유 사이트 기트허브(github)에 올렸다고 발표했다. MS 아시아 리서치 랩에서 만든 DMTK는 개발자들이 쉽게 기계학습 프로그램을 조절할 수 있도록 해주는 서버 기반 프레임워크에 기반을 둔다. 다양한 업무용으로 컴퓨터를 쉽게 훈련시키기 위해 MS가 개발한 알고리즘 2개도 포함됐다.

페이스북의 성과

페이스북의 최고기술경영자(CTO)인 마이크 슈뢰퍼(Mike Schroepfer)는 그간 오랫동안 연구해온 인공지능 리서치(https://research.facebook.com)에 대한 그간의 성과를 2015년 11월 발표했다(Facebook, 3 Nov 2015; Recode, 9 Nov 2015). 이 성과는 페이스북의 인공지능 리서치(Facebook’s AI Research, FAIR, https://research.facebook.com/ai) 팀으로부터 나온 것이다. 이 연구에서는 인공지능 컴퓨터와 소프트웨어를 훈련시키고 학습시켜 사진 속에서 사물과 인물을 구별하고, 여기에 자연언어를 융합한다. 더 나아가 예측(predict)과 계획(plan)을 할 수 있는 능력이 포함돼 있으며, 또한 개인 음성 비서인 ‘M’도 포함돼 있다.

사물감지(Object detection)

2015년 12월 12일 FAIR 팀은 NIPS(Neural Information Processing Systems) 컨퍼런스에서 추론(reasoning), 집중(attention), 기억(memory)이라는 주제(RAM)로 논문을 발표했다(RAM, NIPS Workshop 2015)(Facebook Research, 2015).

팀원들은 사진에서 사물을 구별해내는 방법과 세그먼트로 나누어 카테고리화 하는 새로운 최첨단 시스템을 발표했다. 이 새로운 시스템은 사진의 이미지들을 구별해 세그먼트와 카테고리로 나눌 때 10배나 적은 빅데이터를 사용하지만 기존 방식보다 30%나 빠르다. 이는 비지도학습의 ML-DL이다(그림 9).

자연언어 이해가 이미지 인식을 만나다

2015년 3월 페이스북은 ‘F8 2015’ 개발자 컨퍼런스에서 ‘자연언어 이해’라는 몇 가지 연구를 발표했는데(Facebook - F8 2015, 26 Mar 2015), ‘바로 메모리 네트워크(MemNets, Memory Networks)’라 부르는 시스템이었다. 그 당시 이 시스템은 짧은 텍스트를 읽고 질문에 답했다.

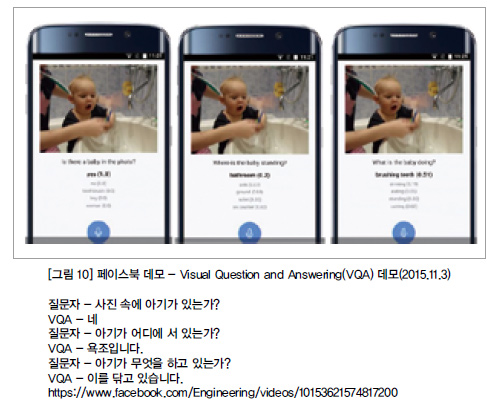

그런데 업그레이드된 새로운 시스템은 VQA(visual Q&A)라 불리는데, 메모리 네트워크에 이미지 인식 기술이 융합돼 사람들이 VQA에 ‘사진 속에 무엇이 있는가?’라고 물으면, 사진 속 이미지들이 무엇이며 무엇을 하고 있는지를 알려주는 것이다.

그림 10은 엄마가 아기를 욕조 안에 세우고 아기의 이를 닦아주는 사진이다. 이것도 비지도학습의 ML-DL이다.

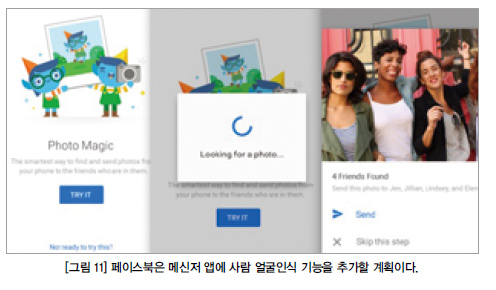

사진 속 사람 얼굴인식 기술

그 동안 인공지능 기술에 많은 투자를 해온 페이스북은 이제 실제 제품에 통합하는 작업에 박차를 가하고 있다. 2015년 11월 외신들은 페이스북이 메신저 앱에 사람 얼굴인식 기능을 추가할 계획이라고 보도했다(Recode, 9 Nov 2015). 이미 지금도 사진을 찍어 페북에 올리면, 사진에 찍힌 사람이 친구로 등록돼 있을 경우 자동으로 그 사진 속 친구가 누구인지 인식되어 사진에 친구의 이름을 띄워주고, 태그할 것인지 말 것인지를 결정하라고 한다(그림 11). 처음 접할 때는 섬뜩하다는 느낌이 들 정도다. 또한 사진 저장 앱인 모먼트(Moments)에도 얼굴인식 기능을 이미 적용했다.

페이스북은 더 나아가 사용자가 촬영한 사진을 메신저로 보낼 경우 메신저 앱이 살펴본 뒤 사진 속 인물의 얼굴을 인식한 후 친구들과 해당 사진을 공유하라고 추천까지 해준다. 이것도 비지도학습의 ML-DL이다.

페이스북이 인공지능 기술을 제품에 접목시키는 것은 사용도와 참여도, 관심도 등을 높이기 위한 것이다. 페이스북 메신저가 친구에게 공유할 사진을 자동으로 골라서 추천해준다면 다른 메시징 앱보다 사용자가 더 많이 사용할 가능성이 높아지기 때문이다.

그러나 사람들이 스마트하다고 느끼도록 제품을 만들 필요는 있으나 지나치게 똑똑해서 무섭게 느껴지지 않도록 해야 한다. 얼굴인식 기술이 메신저에 통합됐을 때 이런 느낌을 받는다면 설정에서 얼굴인식 기능을 꺼버릴 수도 있기 때문이다. 얼굴인식 기능이 추가된 메신저 업데이트는 아직 호주에서만 실시되고 있으나, 소비자들의 반응을 봐서 곧 확대할 전망이다.

예측 학습

관리자나 감독, 교사의 지도 없이 예측 학습(비지도 예측 학습, Unsu-pervised Predicting Learning)을 한다는 것은 경험적인 지식이나 관찰에 의한 학습을 바탕으로 미래에 어떤 일이 일어날 수 있는지 이해할 수 있는 능력이 있다는 것이다. 컴퓨터에 이러한 능력을 부가하기 위해 FAIR 팀은 일련의 비주얼(시각적) 테스트를 볼 수 있는 하나의 시스템을 개발해왔는데, 예를 들어 불안정하게 쌓아놓은 블록들로, 이 블록들은 쌓는 구조에 따라 떨어질 수도 안 떨어질 수도 있는 상황이다. 그리고 그 결과를 컴퓨터가 예측하게 하는 것이다.

몇 개월의 연구 끝에 FAIR 팀은 인간보다 훨씬 나은, 시간이 경과함에 따라 떨어지거나 안 떨어질 확률을 90%까지 정확하게 예측하는 시스템을 개발했다(그림 12).

인공지능 바둑기사

인공지능 컴퓨터가 인간과의 체스게임에서 이긴 것은 1997년의 일이다. 지난 1월엔 마침내 인공지능 컴퓨터가 프로 바둑기사를 이겼다. 그리고 지난 3월 10여년째 바둑 세계 챔피언 자리를 지키고 있는 이세돌 9단을 4:1로 이겼다. 구글의 자회사 구글 딥마인드가 개발한 인공지능 바둑 프로그램 ‘알파고’ 얘기다.

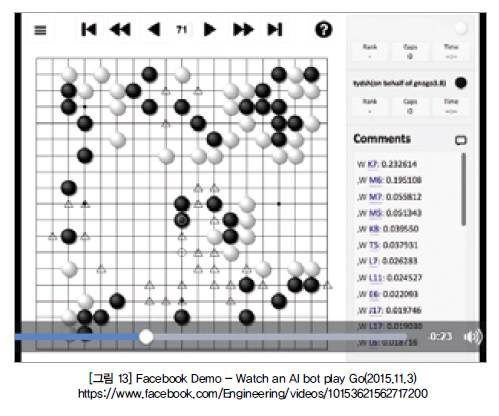

인공지능 훈련에 각종 게임을 활용하는 것은 이제 상당히 보편화된 접근방법 중 하나다. 그 중에서도 바둑의 높은 난이도는 인공지능에게 복잡한 패턴 인식 기능을 훈련시키는 데 제격이다. 바둑은 전 세계에 존재하는 말판놀이 중 가장 어려운 게임 중 하나로 잘 알려져 있다. 다른 경기에 비해 상대방의 다음 수를 예측하기가 월등히 어렵기 때문이다. 단적인 예로 체스의 경우, 양쪽 선수가 처음 한 수씩 둔 다음 수를 둘 때 발생 가능한 패턴은 400여 가지에 불과한 반면, 바둑은 이론적으로 약 13만 가지 패턴이 나타날 수 있다. 페이스북은 이런 어려움을 공략하기 위해 인공지능에게 시각적 정보로부터 다양한 패턴을 읽어내는 능력을 부여하고 있다. 이 또한 비지도학습방법이다.

마이크 슈뢰퍼는 “인간 바둑기사들도 바둑판 위에 펼쳐진 시각 정보로부터 패턴을 분석해 직관적으로 좋은 수를 찾아내는 능력을 가지고 있을 것이라 생각한다”며 “이와 유사하게 우리도 인공지능에 시각적 인식 기능을 더해 다음 수를 생각해낼 수 있도록 만들고 있다”고 말했다. 따라서 FAIR 팀은 컴퓨터 시스템에게 어떻게 계획하는지 그 방책을 가르쳐주기 위해 보드 게임인 바둑(Go)을 둘 수 있는 AI 봇(bot)을 개발했다.

몇 달 훈련시킨 뒤, 이 AI 봇은 시중에 출시된 대부분의 바둑 프로그램을 이길 수 있게 됐고, 일부 뛰어난 인간 기사들만큼의 역량을 보여주고 있다. 게임의 진행 과정에서 움직일 수 있는 모든 가능한 이동 경로들을 모델링하는 전통적인 검색 방법에 FAIR 팀이 개발한 패턴(pattern)을 매칭하는 시스템을 융합해서 AI 봇을 만들었다(그림 13).

지도학습으로 인간과 같은 음성 비서 ‘M’

이러한 일련의 ML-DL 소프트웨어는 페이스북의 음성 비서인 ‘M’으로 융합될 것이다. 현재 M은 엄청나게 똑똑한데, 주문한 제품을 배달해 줄 수 있고, 오늘 비가 온다고 예보해 줄 수 있으며, 귀갓길에 세탁물을 픽업하라고 말해 줄 수 있다(Recode, 3 Nov 2015).

페이스북 AI 플랫폼 ‘윗에이아이’(wit.ai)의 책임자인 알렉산더 르브런(Alexandre Lebrun)은 “이러한 M 서비스가 가능한 것은 고객의 데이터다. 모든 것이 데이터의 문제다. 만약 고객이 꽃을 사는 것과 관련된 대화 정보를 보유하고 있지 않다면, 유일한 방법은 고객의 다른 데이터를 이용해 고객이 좋아하는 꽃에 대한 정보를 만드는 것이다”고 말했다(FT, 17 Nov 2015).

르브런은 애플과 MS가 음성인식 개인비서 서비스인 ‘시리’와 ‘코타나’의 수준을 높이는 데 어려움을 겪는 것도 데이터 부족에 따른 것이라고 지적했다. 이 때문에 이용자들은 시리나 코타나가 할 수 있는 일과 할 수 없는 일을 구분해 날씨 묻기 등 제한적인 용도로 서비스를 활용할 수밖에 없다고 덧붙였다.

그러나 페이스북의 M은 날씨 말하기 등 특정 서비스를 하도록 프로그램 되지는 않았다. 대신 페이스북 이용자들의 방대한 대화 자료를 학습한다. 애플과 MS, 구글도 ML-DL에 집중하고 있지만 페이스북만큼 방대한 사회적 데이터를 갖지 못해 고전하고 있다. 르브런은 2015년 3월부터 내부에서 시험 가동 중인 M은 사회적 데이터를 통한 학습으로 농담까지 할 수 있는 수준이 됐다고 설명한다. 다만 그는 문화, 언어 등과 관련한 지역차 등 장기 프로젝트인 M이 직면한 도전도 만만치 않다고 언급했다.

페이스북은 매달 계정으로 접속하는 고객 15억 명의 경험 데이터를 이용해 스마트 기기의 CPU로 하여금 어떠한 고객의 원하는 작업을 실행하도록 학습시키는, 실제 인간의 역할을 하는 M을 AI 제품에 융합시키려 하고 있다. 그러면 페이스북은 엄청난 기회를 포착할 것인데, 사람들로 하여금 메신저를 사용하면서 메신저 안에서 쇼핑과 모바일 상거래를 할 수 있도록 해주기 때문이다.

알렉산더 르브런은 “페이스북은 실명의 이용자 15억 명으로부터 얻은 방대한 사회적 데이터로 독보적인 자리(unique situation)에 있다”고 말한다. 구글, MS, 애플이 음성 비서에게 훈련시키는 방법인 비지도학습 대신에, 페이스북은 지도학습으로 M에게 훈련시키는 교사/감독자들로 이루어진 팀을 구성하고 있다.

M은 사실 소프트웨어라기보다는 사람을 많이 닮았다. 아직 질문에 대한 기본적인 답을 해주는 것을 학습하는 초기 단계이지만, 마이크 슈뢰퍼에 따르면 실제 사용자들과의 상호작용을 조절할 수 있는 단계라고 한다. 그는 “M은 사람들에 의해 학습(지도학습)하고 지능을 터득하고 있다. 사람들은 우리의 AI를 위해 아주 효과적으로 백업하고 있다. 사용자들은 그들이 실제 원하는 어떤 질문도 할 수 있다”고 말했다.

페이스북은 M에게 지도학습으로 훈련시키고 있다. 예를 들어 사용자가 A를 물으면 B라고 대답하는 과정을 학습 중이다. 그리고 궁극적으로는 감독자의 지도 없이 스스로 고객들로부터 학습하고 대답하는 것이다. 사실 사물-사람-동물의 이미지나 영상 데이터를 분석하는 데에는 비지도학습이 적격일 것이다. 그러나 스마트 기기의 CPU에서 구동되는 M은 최전방의 고객접점에 있는 고객들을 지원하기 위해, 처음 단계에서는 트레이너에 의한 지도학습을, 궁극적으로는 고객들로부터의 지도학습을 시키는 것이 가장 바람직할 것이다.

페이스북은 앞서 소개한 메모리 네트워크 외에 신경망 네트워크를 구축했는데, 이는 기계가 사람처럼 생각하고 행동하도록 하는 애플리케이션이다. 마이크 슈뢰퍼에 따르면, 이미 M 속에 이러한 많은 애플리케이션이 살아 움직인다고 한다. 곧 M은 사람(감독) 의존적인 것을 탈피하고 베타테스트 모드로 들어간다. 마이크 슈뢰퍼는 “이는 그만큼 확장성이 있다는 것으로 매우 흥분된다. 우리는 전 세계 70억 명을 대상으로 개인 비서 서비스를 할 것인데, 이를 위해 수많은 감독자나 교사를 고용할 수는 없는 일”이라고 말했다.

페이스북은 이를 위해 사용자들의 빅데이터를 백업 저장한다. 사진이나 동영상의 유지 기간은 사용자가 허락할 때까지 존속하지만, 2015년 11월에 페이스북은 스냅챗(Snapchat)처럼, 프랑스에서 사람들이 메신저로 메시지를 보낸 뒤 1시간 뒤에 사라지는 기능을 테스트한다고 공식 발표했다(BuzzFeed, 13 Nov 2015). 이 경우 고객의 프라이버시를 중시하는 애플처럼 빅데이터를 저장하지 않기 때문에 실시간 스트리밍 상에서 인구/지역/성별 등 세그먼트로 나누어 패턴을 찾아 서비스하는 기계학습을 적용할 가능성이 높다.

사실 페이스북은 몇 명이 M에 매달려 연구 관리하고 있는지 공개를 꺼리지만, 버지피드(BuzzFeed)는 페이스북이 태스크래빗(TaskRabbit, https://www.taskrabbit.com)이라는 외부 업체와 협력하고 있다고 보도했다(BuzzFeed, 3 Nov 2015). 물론 애플과 구글 또한 iOS와 안드로이드 디바이스에 각각의 똑똑한 시리와 나우의 개인비서를 만들기 위해 경쟁하고 있다. 이들 개인비서들은 앱으로 다운받는 것이 아니라 아예 탑재돼 출시되고 있다. 이런 점에서 애플과 구글은 메신저 시장을 타깃으로 하는 페이스북보다는 한 수 앞서 있다. 그러나 지금 딥러닝 전문가들이 그리 많지 않다는 점에서, DL의 1인자인 얀 레쿤(Yann Lecun)을 영입한 페이스북은 구글과 애플보다 한 수 위에 있기 위해 지금 피치를 올리고 있다.

페이스북은 매 분기 매출액의 30%, 13억 달러에 달하는 돈을 연구개발에 투자하고 있다. 자세한 내용은 알 수 없지만, 이중 일부는 음성 비서인 M과 ML-DL에 장기적으로 투자하고 있다.

결론 및 인사이트

페이스북의 AI-ML-DL 연구는 앞서 언급한 분야로만 국한해서 보면 안 될 것이다. 인프라가 구축 되지 않아 인터넷을 사용하지 못하는 전 세계 40억 인구를 하나의 네트워크로 연결하겠다는 커넥티비티랩(Connectivity Lab)과 연동돼 있다. 성층권(stratosphere)에 무인항공기를 띄우는 프로젝트인 아퀼라(Aquila)를 추진하고 있는데(Facebook, 31 Jul 2015), 만약 40억 인구가 저렴한 인터넷에 연결된다면 AI-ML-DL 연구에 필요한 빅데이터를 바탕으로 그 활용분야는 무궁무진할 것이다.

또한 페이스북이 인수한 오큘러스 리프트(Oculus Rift)를 중심으로 추진하고 있는 증강/가상현실(AR/VR)과도 밀접한 관계가 있다(Facebook, 24 Sep 2015). 증강/가상현실을 추진하고 있는 이유는 사회적 트렌드가 저 출산에 따른 1인가구의 솔로 경제(Solo Economy)가 등장하기 때문이다. 2030년 솔로 경제의 특징은 솔로들이 고령자보다 무려 5배 이상의 생산성을 올려야 사회를 먹여 살릴 수 있다는 것이다.

이를 지원하자는 것이 바로 협업할 수 있는 증강/가상현실이다. 원격지에 떨어져 있어도 클라우드 베이스로 프로젝트를 여러 개 진행할 수 있으므로 차세대 통신, 차세대 경험 공유, 차세대 협업으로 적격이다. 여기에 인공지능이 가세한다고 생각해보라. 그것은 우리의 생활방식을 바꾸게 될 것이다.

이는 또한 솔로 경제의 1인 개인방송과도 밀접한 관계가 있다. 페이스북이 도입한 멘션(https://www.facebook.com/about/mentions)에 AI-ML-DL이 융합된다고 생각해보라. 2014년 말 서비스를 시작한 멘션은 페이스북 내 유명인만을 위한 공간이었다. 연예인, 스포츠 스타, 정치인들이 자신을 좋아하는 팬들과 소통하는 공간으로 마련됐다. 최근 페이스북은 이용자층을 확대한다고 발표했다.

이러한 관점에서 한국 기업들은 나락에 빠지는 느낌이다. 특히 스마트 기기 제조사들은 스마트 디바이스(깡통, D)가 중요한 것이 아니라 고객의 데이터가 중요하다는 사실을 알았어야 하는데, 사실 솔직히 말하면 고객의 데이터를 끌어 모을 아무런 툴도, 소프트웨어도, 플랫폼도 가지고 있지 않다. 몇몇 국내 인터넷 사업자와 통신사업자는 AI-ML-DL을 도입해 추진한다고 한다. 핵심 역량의 비즈니스와 경쟁사들을 잘 분석해 나름대로의 차별화를 꾀하여 추진해야 할 것이다.

역시 가장 중요한 인사이트는 AI-ML-DL의 최고 전문가를 영입해야 한다는 것이다. 세계의 4인방은 구글-페이스북-바이두로 향했다. 5인자가 있다면 5인자라도 영입해야 할 것이다. 그러나 5인자~10인자가 있다면 과연 한국 기업에 올까?

마지막으로 알고리즘만 잘 설계했다고 해서 ML-DL이 자동으로 구현되는 것은 아니라는 것이다. 지도학습이든 비지도학습이든 무수히 많은 훈련을 시켜야 한다는 사실이다. 구글이 자사의 ML-DL 시스템이 고양이를 제대로 구분할 수 있도록 하기 위해 수백만 장의 사진과 유튜브 동영상 1천만 개를 올려 비지도학습 훈련을 시켰다는 것만 봐도 쉽게 짐작할 수 있다. 앞서 설명한대로 페이스북도 여러 가지 테스트 장비나 AI 봇을 만들어 비지도학습으로 훈련시키고 있음도 확인했다.

이런 훈련 작업을 하는 데는 수백만 개 이상의 매개변수가 영향을 미치게 된다. 따라서 이런 매개변수를 잘 처리할 수 있는 엔지니어가 있어야만 ML-DL 노하우를 제대로 축적할 수 있다. 다시 말해 구글과 페이스북의 알고리즘을 손에 넣었다고 해서 금방 ML-DL 작업을 잘 할 수 있는 건 아니란 얘기다. 수많은 실험을 통해 여러 가지 시행착오를 거쳐야만 ML-DL의 수준을 높일 수 있다.

<저작권자(c)스마트앤컴퍼니. 무단전재-재배포금지>