엔비디아 베라 CPU, 루빈 GPU, NV링크 6 스위치, 커넥트X-9 슈퍼NIC, 블루필드-4 DPU, 스펙트럼-6 이더넷 스위치 공동 설계

엔비디아(CEO 젠슨 황)가 미국 라스베이거스에서 열린 세계 최대 IT·가전 전시회 CES 2026에서 차세대 AI를 위한 엔비디아 루빈(NVIDIA Rubin) 플랫폼을 출시한다고 밝혔다.

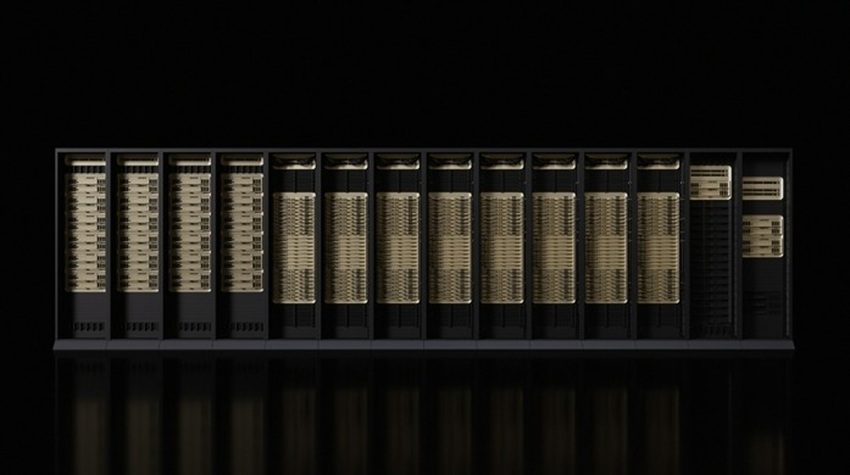

루빈 플랫폼은 첨단 AI 슈퍼컴퓨터를 구현하도록 설계된 신규 칩 6종으로 구성된다. 엔비디아 루빈은 세계 최대 규모의 최첨단 AI 시스템을 구축, 배포하고 보안을 강화하는 새로운 기준을 제시하며, 이를 최저 비용으로 구현해 AI의 대중화를 가속한다고 업체 측은 밝혔다.

루빈 플랫폼은 6개 칩 전반에 걸쳐 고도의 공동 설계를 적용해 훈련 시간과 추론 토큰 비용을 절감한다. 6개 칩에는 엔비디아 베라(Vera) CPU, 엔비디아 루빈 GPU, 엔비디아 NV링크 6 스위치(NVLink 6 Switch), 엔비디아 커넥트X-9 슈퍼NIC(ConnectX-9 SuperNIC), 엔비디아 블루필드-4(BlueField-4) DPU, 엔비디아 스펙트럼-6 이더넷 스위치(Spectrum-6 Ethernet Switch)가 포함된다.

엔비디아 창립자 겸 CEO 젠슨 황(Jensen Huang)은 "AI 훈련과 추론을 위한 컴퓨팅 수요가 어느 때보다도 급증하고 있는 가운데, 루빈의 등장은 매우 시의적절하다"라며, "엔비디아는 매년 차세대 AI 슈퍼컴퓨터를 선보이고 있다"고 밝혔다. 이어 "이러한 가운데, 6개 칩에 고도의 공동 설계를 적용한 루빈은 AI의 새로운 지평을 향해 비약적인 발전을 이룰 것”이라고 말했다.

루빈 플랫폼은 우주에 대한 인류의 이해를 변화시킨 선구적인 미국 천문학자 베라 플로렌스 쿠퍼 루빈(Vera Florence Cooper Rubin)의 이름을 따서 지었다. 이 플랫폼은 엔비디아 베라 루빈 NVL72 랙 스케일 솔루션과 엔비디아 HGX 루빈 NVL8 시스템으로 구성된다.

루빈 플랫폼은 최신 엔비디아 NV링크 인터커넥트 기술, 트랜스포머 엔진(Transformer Engine), 컨피덴셜 컴퓨팅(Confidential Computing), RAS 엔진(RAS Engine), 엔비디아 베라 CPU를 포함한 5개의 혁신 기술을 도입한다. 이는 에이전틱 AI, 고급 추론, 대규모 전문가 혼합 방식(mixture-of-experts, MoE) 모델 추론을 가속화해 토큰당 비용을 엔비디아 블랙웰(Blackwell) 플랫폼 대비 10배 절감시킨다. 또한 엔비디아 루빈 플랫폼은 MoE 모델 훈련에 필요한 GPU 개수를 이전 대비 4배 절감해 AI 도입을 가속할 전망이다.

"루빈은 AI의 새로운 지평을 향해 비약적인 발전을 이룰 것”

루빈 플랫폼은 전 세계의 선도적인 AI 연구소, 클라우드 서비스 제공업체, 컴퓨터 제조업체, 스타트업으로부터 광범위하게 채택될 것으로 예상된다. 여기에는 아마존 웹 서비스(Amazon Web Services, AWS), 앤트로픽(Anthropic), 블랙 포레스트 랩스(Black Forest Labs), 시스코(Cisco), 코히어(Cohere), 코어위브(CoreWeave), 커서(Cursor), 델 테크놀로지스(Dell Technologies), 구글(Google), 하비(Harvey), 휴렛팩커드 엔터프라이즈(Hewlett Packard Enterprise, HPE), 람다(Lambda), 레노버(Lenovo), 메타(Meta), 마이크로소프트(Microsoft), 미스트랄 AI(Mistral AI), 네비우스(Nebius), 엔스케일(Nscale), 오픈AI(OpenAI), 오픈에비던스(OpenEvidence), 오라클 클라우드 인프라스트럭처(Oracle Cloud Infrastructure, OCI), 퍼플렉시티(Perplexity), 런웨이(Runway), 슈퍼마이크로(Supermicro), 싱킹 머신즈 랩(Thinking Machines Lab), xAI 등이 있다.

에이전틱 AI, 추론 모델, 최첨단 비디오 생성 워크로드는 컴퓨팅의 한계를 재정의하고 있다. 다단계 문제 해결을 위해서는 모델이 긴 시퀀스의 토큰을 처리하고 추론하며 그에 따라 행동할 수 있어야 한다

.

새로운 종류의 AI 네이티브 스토리지 인프라

엔비디아 루빈은 기가스케일 규모의 추론 컨텍스트 확장을 위해 설계된 새로운 종류의 AI 네이티브 스토리지 인프라인 ‘엔비디아 추론 컨텍스트 메모리 스토리지 플랫폼(Inference Context Memory Storage Platform)’을 도입했다.

엔비디아 블루필드-4로 구동되는 이 플랫폼은 AI 인프라 전반에 걸쳐 키-밸류(key-value, KV) 캐시 데이터를 효율적으로 공유하고 재사용하도록 지원함으로써 반응성과 처리량을 크게 향상시킨다. 동시에 에이전틱 AI의 예측 가능하며 전력 효율적인 확장을 가능하게 한다.

점차 많은 AI 팩토리가 베어 메탈(bare-metal), 멀티 테넌트(multi-tenant) 배포 모델을 채택함에 따라 강력한 인프라 제어 유지와 격리가 필수적인 요소로 부각되고 있다.

블루필드-4는 ‘고급 보안 신뢰 자원 아키텍처(Advanced Secure Trusted Resource Architecture, ASTRA)’를 도입했다. 이는 AI 인프라 빌더가 성능 저하 없이 대규모 AI 환경을 안전하게 프로비저닝, 격리, 운영할 수 있도록 신뢰 가능한 단일 제어점(control point)을 제공하는 시스템 수준의 신뢰 아키텍처다.

AI 애플리케이션이 멀티턴(multi-turn) 에이전틱 추론으로 발전함에 따라, AI 네이티브 조직은 훨씬 더 많은 양의 추론 컨텍스트를 다양한 사용자, 세션, 서비스 간에 걸쳐 효율적으로 관리하고 공유해야 한다.

엔비디아 베라 루빈 NVL72는 엔비디아 루빈 GPU 72개, 엔비디아 베라 CPU 36개, 엔비디아 NV링크 6, 엔비디아 커넥트X-9 슈퍼NIC, 엔비디아 블루필드-4 DPU를 결합해 안전한 통합 시스템을 제공한다.

또한 엔비디아는 HGX 루빈 NVL8 플랫폼을 제공할 예정이다. 이는 루빈 GPU 8개를 NV링크로 연결해 x86 기반 생성형 AI 플랫폼을 지원하는 서버 보드이다. HGX 루빈 NVL8 플랫폼은 AI와 고성능 컴퓨팅 워크로드를 위한 훈련, 추론, 과학 컴퓨팅 워크로드를 가속화할 것이다.

엔비디아 DGX SuperPOD™는 루빈 기반 시스템을 대규모로 배포하기 위한 레퍼런스 역할을 수행한다. 이는 엔비디아 DGX 베라 루빈 NVL72 또는 DGX 루빈 NVL8 시스템을 엔비디아 블루필드-4 DPU, 엔비디아 커넥트X-9 슈퍼NIC, 엔비디아 인피니밴드 네트워킹, 엔비디아 미션 컨트롤™ 소프트웨어와 통합한다.

고급 이더넷 네트워킹과 스토리지는 AI 인프라의 구성 요소

데이터센터의 속도를 최고로 유지하고 성능과 효율성을 개선하며 비용을 절감하는 데 핵심적이다.

엔비디아 스펙트럼-6 이더넷은 AI 네트워킹을 위한 차세대 이더넷으로, 높은 효율성과 탁월한 복원력을 기반으로 루빈 기반 AI 팩토리의 확장을 위해 설계됐다. 이는 200G 서데스(SerDes) 통신 회로, 공동 패키징 옵틱(co-packaged optics), AI 최적화 패브릭 기술을 통해 구현된다.

스펙트럼-6 아키텍처를 기반으로 구축된 스펙트럼-X 이더넷 포토닉스 공동 패키징 옵티컬 스위치 시스템(Photonics co-packaged optical switch systems)은 AI 애플리케이션에 대해 10배 향상된 신뢰성과 5배 더 긴 가동 시간을 제공한다. 동시에 5배 향상된 전력 효율성을 달성하며 기존 방식 대비 와트당 성능을 극대화한다. 스펙트럼-X 이더넷 플랫폼의 일부인 스펙트럼-XGS(Spectrum-XGS) 이더넷 기술은 수백 킬로미터 이상 떨어져 있는 시설에서도 단일 AI 환경처럼 기능할 수 있도록 지원한다.

이러한 기술은 엔비디아 스펙트럼-X 이더넷 플랫폼의 차세대 혁신을 제시한다. 루빈을 위해 고도로 공동 설계된 이 플랫폼은 대규모 AI 팩토리 구현을 가능하게 하며, 향후 수백만 GPU 규모 환경으로의 확장을 위한 토대를 마련한다.

<저작권자(c)스마트앤컴퍼니. 무단전재-재배포금지>