?‘마이아 200’?GPT-5.2 최적화·엔드투엔드 설계로 AI 인프라 효율성 강화

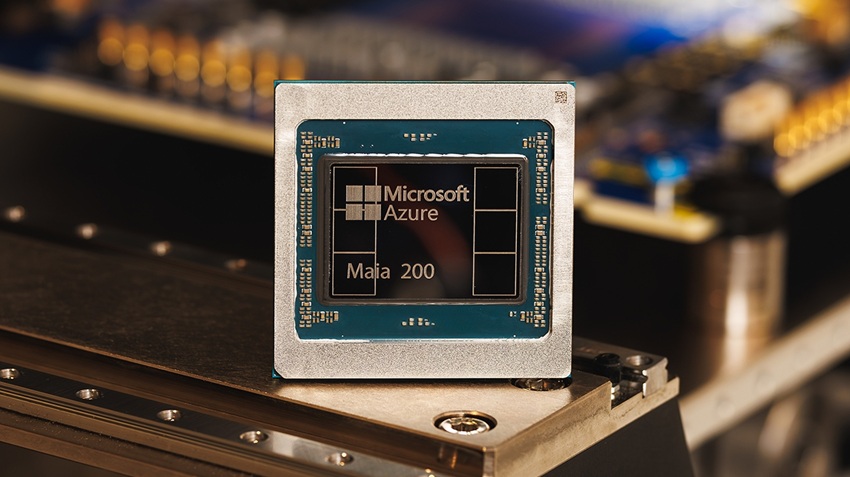

마이크로소프트가가 대규모 AI 추론 워크로드의 경제성과 성능을 동시에 개선하기 위해 설계된 차세대 AI 추론 가속기 ‘마이아 200(Maia 200)’을 공개했다. 마이아 200은 마이크로소프트의 클라우드 플랫폼?마이크로소프트 애저 환경에서 AI 모델을 보다 빠르고 효율적으로 구동하도록 설계됐으며, 차세대 AI 인프라의 핵심 구성 요소로 활용될 예정이다.

마이아 200은 TSMC의 3나노미터 공정을 기반으로 제작됐으며, 1,400억 개 이상의 트랜지스터를 집적한 고성능 AI 추론 전용 아키텍처를 갖췄다. 216GB HBM3e 메모리와 초당 7TB 대역폭의 메모리 하위 시스템, 네이티브 FP8·FP4 텐서 연산 지원, 데이터 이동 엔진을 유기적으로 결합해 대규모 언어 모델 추론에 최적화된 성능을 제공한다.

마이크로소프트에 따르면 마이아 200은 FP4 기준에서 아마존의 3세대 트레이니움 대비 약 3배 높은 처리량을 기록했으며, FP8 기준에서도 구글의 7세대 TPU를 상회하는 성능을 보였다. 이를 통해 자사 최신 세대 하드웨어 대비 달러당 성능(Performance per Dollar)을 약 30% 개선했다.

마이아 200은 OpenAI의 최신 GPT-5.2 모델을 포함한 다양한 AI 모델을 지원하며, 마이크로소프트 파운드리(Microsoft Foundry)와 마이크로소프트 365 코파일럿(Microsoft 365 Copilot) 등 주요 서비스의 가격 대비 성능 효율을 높이는 데 활용된다. 또한 마이크로소프트 슈퍼인텔리전스 팀은 합성 데이터 생성과 강화학습 기반 모델 개선에도 마이아 200을 투입할 계획이다.

인프라 차원에서는 칩 단위 성능에 그치지 않고, 데이터센터까지 아우르는 엔드투엔드 통합 설계를 적용했다. 마이크로소프트는 표준 이더넷 기반의 2계층 스케일업 네트워크와 통합 NIC를 도입해 독점 패브릭 없이도 대규모 클러스터 환경에서 성능과 비용 효율을 동시에 확보했다. 각 가속기는 초당 2.8TB의 양방향 대역폭을 지원하며, 최대 6,144개 가속기를 연결하는 환경에서도 일관된 성능을 유지하도록 설계됐다.

개발 및 배포 측면에서도 인프라 혁신 주기를 크게 단축했다. 마이크로소프트는 칩 설계 초기 단계부터 LLM 연산 및 통신 패턴을 모델링하는 프리 실리콘 환경을 구축하고, 네트워크·냉각·시스템 소프트웨어를 함께 검증했다. 그 결과 마이아 200은 부품 입고 후 수일 내 실제 모델 구동에 성공했으며, 칩 도입부터 데이터센터 배치까지의 기간을 기존 대비 절반 이하로 줄였다.

<저작권자(c)스마트앤컴퍼니. 무단전재-재배포금지>